DATA Analytics Pipelines :

Préparation / Analyse / Déploiement

Création d'un data pipeline

DATA Analytics Pipelines

Nos Data Architects vous accompagnent sur votre infrastructure et la mise en place de pipelines de CI/CD sécurisés et robustes afin de gagner du temps lors de vos déploiements de code

Nos Data Engineers experts vous accompagneront dans la construction de pipelines optimisés pour alimenter vos modèles en data (streaming ou batch) tout en veillant au maintien de la qualité dans le temps.

1. Préparation

Intégration des données

Rassembler les données à partir de sources variées, telles que des bases de données, des fichiers, des APIs, ou des données provenant de capteurs par exemple

Exploration des données

Analyse des structures, formats, et caractéristiques ainsi que et leurs problèmes éventuels. Cela aide à identifier les valeurs manquantes, les duplications ou les incohérences et à préparer la phase de nettoyage. Une fois cette première évaluation effectuée, nous pouvons procéder au nettoyage des données

Nettoyage des données

Cette phase consiste en la correction des erreurs ou des incohérences trouvées lors de l'exploration des données. Par exemple traitement des valeurs nulles, conversion de formats de données, interpolation ou remplacement des données manquantes. A l'issue de cette phase le dataset sera exploitable, nous procédons alors à d'éventuelles transformations en vue de l'analyse définitive

Transformation des données

Phase où les données sont modifiées pour les adapter aux besoins spécifiques de l'analyse. Cela peut inclure la normalisation des données pour les mettre à l'échelle, la conversion de formats de données, l'agrégation, la discrétisation. Exemple d'aggrégation: grouper des points de données par période de temps pour réduire le volume de données si le besoin existe (par exemple un capteur délivre des points de données toutes les secondes et nous n'avons besoin que d'une échelle de la minute pour l'analyse)

2. Analyse

Analyse des KPI

Identification des structures de données et opérations pertinentes à effectuer pour chaque key performance indicator. Extraction et processing des données pertinentes par KPI

Prototypage des visualisations

Séléction des modèles de charts les mieux adaptés à chaque KPI et affinage en fonction les types de données disponibles et du résultat attendu (séries temporelles, catégorielles, numériques, etc)

3. Déploiement

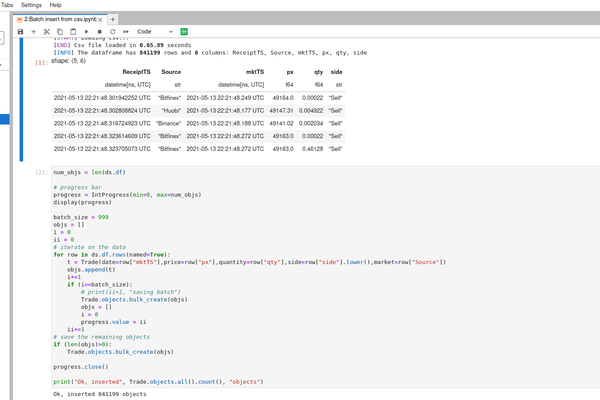

Création d'un data pipeline

Les opérations ci-dessus sont automatisées dans un process. En entrée la data brute passera par différentes étapes de traitement pour en sortie créer les charts et éléments prévus. En cas de nouvelles données ce process peut être lancé pour updater les visualisations

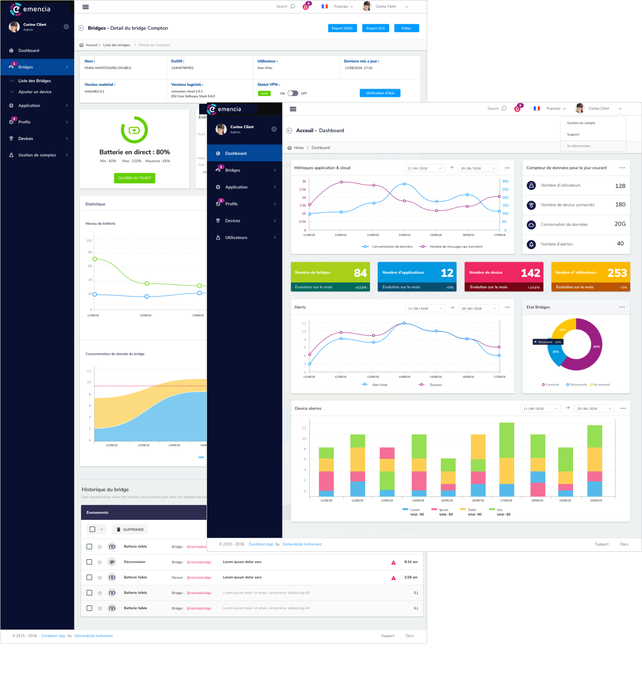

Assemblage du dashboard

Travail de frontend pour présenter les différentes parties du dashboard: charts, navigation, pages ou structure de l'application. Intégration des contraintes de sécurité (login, api keys ou autre selon projet)

Intégration du dashboard

Dans un site existant ou sous forme de service indépendant sécurisé avec utilisateurs enregistrés et autorisations

Déploiement du service en production

Déploiement du service en production : Cloud, Docker, Kubernetes, Ansible. Mise à disposition de la donnée via une API, intégration à un site Internet existant ou une application métier. Génération et distribution des extracts de rapports automatisés (par email, format PDF, CSV, XLS....)